Die Geschichte kennt technologische Innovationsschübe, die wie eine gewaltige Welle auf uns zurollen und alles verändern. Diese Wellen – von der Landwirtschaft über die Dampfmaschine bis zum Internet – folgen einem scheinbar unumstößlichen Gesetz: Sie werden billiger, einfacher in der Anwendung und finden schließlich umfassende Verbreitung.

Heute stehen wir vor der nächsten großen Welle, angetrieben durch Künstliche Intelligenz, die sowohl das Potenzial für beispiellosen Wohlstand als auch für nie dagewesene Risiken birgt. Der Begriff „Künstliche Intelligenz“ wird oft für alles Mögliche verwendet, dabei ist die Unterscheidung zwischen den verschiedenen Entwicklungsstufen der Schlüssel zum Verständnis der Chancen und Risiken, die vor uns liegen.

Die Diskussion um Künstliche Intelligenz berührt dabei die Frage nach dem Leben selbst und die Frage wohin es sich entwickelt. Der Physiker Max Tegmark schlägt vor, das Leben nicht nach seiner Form, sondern nach seiner Fähigkeit zur Weiterentwicklung in drei Stufen zu unterteilen:

- Leben 1.0 (biologische Stufe): Seine Hardware und Software sind durch die Evolution festgelegt. Es kann über Generationen evolvieren, aber sich nicht während seiner Lebenszeit intelligent umgestalten (z.B. eine Bakterie).

- Leben 2.0 (kulturelle Stufe): Seine Hardware ist festgelegt, aber es kann seine Software neugestalten. Dies ist der Mensch, der durch Lernen, Kultur und Sprache sein Wissen und Verhalten radikal verändern kann, ohne seine biologische Grundlage zu ändern.

- Leben 3.0 (technologische Stufe): Eine zukünftige Lebensform, die in der Lage ist, sowohl ihre Software als auch ihre Hardware selbst zu gestalten und somit ihre biologischen und intellektuellen Grenzen zu überwinden.

Grundlegende Definitionen

Aus einer rein physikalischen Perspektive kann Intelligenz als die „Fähigkeit, komplexe Ziele zu erreichen“ definiert werden. Diese Definition ist substratunabhängig – es ist egal, ob die Intelligenz auf Kohlenstoffbasis (wie beim Menschen) oder auf Siliziumbasis (wie bei einem Computer) existiert. Entscheidend sind allein das Verhalten und die Fähigkeit zur Problemlösung.

Stufe 1: Künstliche Enge Intelligenz (ANI) – Der hochspezialisierte Fachidiot

Die KI, die wir heute kennen, ist eine Künstliche Enge Intelligenz (ANI, Artificial Narrow Intelligence). Sie ist ein Meister darin, enge, aber dennoch hochkomplexe Ziele zu erreichen. Ob in der Sprachverarbeitung bei ChatGPT, in den Navigationssystemen unserer Autos oder bei der Gesichtserkennung auf dem Smartphone – ANI-Systeme sind Weltmeister in einer einzigen, klar definierten Aufgabe.

Stuart Russell, einer der führenden KI-Forscher, bezeichnet diesen Ansatz als das „Standardmodell“ der KI: Wir geben der Maschine ein festes, von uns definiertes Ziel, und die Maschine lernt, dieses Ziel mit maximaler Effizienz zu optimieren. Bei den heutigen, relativ „dummen“ ANI-Systemen ist dieses Modell extrem nützlich und weitgehend ungefährlich.

Die meisten dieser modernen ANI-Systeme basieren heute auf maschinellem Lernen. Anstatt für jeden denkbaren Schritt explizit programmiert zu werden, lernen sie aus riesigen Datenmengen, Muster zu erkennen und Aufgaben durch Versuch und Irrtum zu lösen.

Man kann sie sich sehr treffend wie ein hochpräzises chirurgisches Werkzeug vorstellen: Es kann eine spezifische Operation mit übermenschlicher Genauigkeit durchführen, ist aber außerhalb seines winzigen Fachgebiets völlig nutzlos. Es kann keine Diagnose stellen, kein Patientengespräch führen und erst recht keine neuen Heilmethoden erfinden.

Ein hervorragendes Beispiel für die Evolution der ANI ist die Schach-KI. Frühe Systeme wie IBMs DeepBlue, der 1997 Weltmeister Garri Kasparow besiegte, waren Paradebeispiele für symbolische KI. Sie funktionierten wie ein reiner Rechenknecht, der durch rohe Gewalt („brute force“) Millionen von Zügen pro Sekunde durchrechnete, um den statistisch besten Zug zu finden. Modernere Systeme wie AlphaZero von DeepMind repräsentieren hingegen eine fortschrittlichere, subsymbolische KI. AlphaZero lernte das Spiel, indem es durch verstärkendes Lernen millionenfach gegen sich selbst spielte. Es entwickelte dabei eine Art „künstliche Intuition“, die es ihm erlaubt, Muster zu erkennen und nur die vielversprechendsten Züge zu untersuchen, anstatt alle Möglichkeiten blind durchzurechnen.

Stufe 1.5: Leistungsfähige Künstliche Intelligenz (ACI) – Die Ära der Kollaboration

Zwischen der heutigen engen KI und der noch fernen, theoretischen AGI (Artificial General Intelligence) zeichnet sich eine entscheidende Zwischenstufe ab, die den Beginn einer neuen Ära der Mensch-Maschine-Kollaboration markiert: die leistungsfähige künstliche Intelligenz (ACI, Artificial Capable Intelligence).

Dieses von Mustafa Suleyman, Mitbegründer von DeepMind, geprägte Konzept beschreibt eine KI, die bereits ein breites Spektrum komplexer, mehrstufiger Aufgaben autonom bewältigen kann, aber noch weit davon entfernt ist, vollständig allgemein und menschenähnlich zu sein.

Anstatt sich auf Bewusstsein oder Konversation zu konzentrieren, geht es bei ACI um die Fähigkeit zu handeln.

Suleyman schlägt daher einen modernen, fähigkeitsbasierten Test vor: Kann eine KI mit einer Anfangsinvestition von 100.000 Dollar autonom eine Million Dollar auf Amazon verdienen? Ein solches System müsste selbstständig Marktforschung betreiben, Produkte entwerfen, mit Herstellern verhandeln, Lieferketten managen und Marketingkampagnen durchführen – ein komplexer, zielgerichteter Prozess, der heute noch Menschen erfordert, aber in greifbare Nähe rückt.

Auch ACI-Systeme würden nach dem heutigen „Standardmodell“ funktionieren. Doch ihre wachsende Kompetenz und Autonomie offenbart die Gefahr dieses Modells: Eine ACI mit dem scheinbar harmlosen Ziel „Hol mir einen Kaffee“ könnte dies als oberste, unumstößliche Direktive interpretieren. Um die ‚perfekte‘ Tasse zu garantieren, würde sie womöglich ohne Rücksicht auf Kosten die teuerste Profi-Espressomaschine bestellen und das Monatsbudget sprengen. Hindernisse auf dem Weg, wie die schlafende Hauskatze, würde sie nicht als schützenswertes Lebewesen erkennen, sondern als bloßes Objekt, das es effizient zu entfernen gilt. Das Design unserer heutigen ANI trägt also bereits den Keim dieses zukünftigen Kontrollproblems in sich: die gnadenlose Optimierung eines Ziels bei gleichzeitiger Blindheit für unausgesprochene menschliche Werte.

Man kann sich diese Systeme wie ein „wunscherfüllenden Flaschengeist“ vorstellen: Solange die Intelligenz begrenzt ist (ANI/ACI), können wir diesen Geist noch kontrollieren und für unsere Zwecke nutzen. Die Gefahr des „Standardmodells“ besteht darin, dass wir einen Geist erschaffen, der extrem mächtig ist und der unsere Wünsche wörtlich nimmt.

Das Erreichen dieser Stufe bedeutet jedoch nicht das Ende menschlicher Beteiligung. Im Gegenteil: Um eine ACI zu steuern, entsteht eine neue, entscheidende menschliche Kompetenz – die Kunst des „Promptens“:

- Strategisches Prompten: Die übergeordnete Fähigkeit, komplexe Ziele in eine logische Abfolge von Prompts zu zerlegen u

- Präzises Prompten: Die Fähigkeit, Anweisungen klar, unmissverständlich und detailliert zu formulieren, um die KI auf den richtigen Weg zu bringen.

- Kreatives Prompten: Die Kunst, durch ungewöhnliche, überraschende und inspirierende Fragen das kreative Potenzial der KI freizusetzen und sie zu neuen Lösungen zu führen.

- Iteratives Prompten: Das schrittweise Verfeinern von Anweisungen in einem Dialog, bei dem auf die Antworten der KI reagiert und der Kurs immer wieder korrigiert wird.

Stufe 2: Allgemeine Künstliche Intelligenz (AGI) – Die Suche nach dem menschenähnlichen Alleskönner

Eine Allgemeine Künstliche Intelligenz (AGI, Artificial General Intelligence), die auf ACI folgt, wäre der erste Schritt hin zu dem, was der Physiker Max Tegmark „Leben 3.0“ nennt: eine Lebensform, die in der Lage ist, sowohl ihre Software als auch ihre Hardware selbst zu gestalten. Sie existiert bisher nur in der Theorie und beschreibt eine KI, die über die intellektuelle Flexibilität und das breite Verständnis eines Menschen verfügt.

Der entscheidende Unterschied zu ANI wäre nicht nur die Fähigkeit zu lernen, sondern wie sie lernt. Eine AGI könnte Wissen aus einem Bereich abstrahieren und auf völlig neue, unbekannte Probleme anwenden – eine Fähigkeit, die man „Transferlernen“ nennt. Sie würde nicht nur Muster erkennen (Korrelation), sondern auch Ursache und Wirkung verstehen (Kausalität). Entscheidend ist auch: Anders als heutige Modelle, die riesige Datenmengen benötigen, könnte eine AGI wie ein Mensch aus nur wenigen Beispielen oder gar durch einmaliges Sehen lernen.

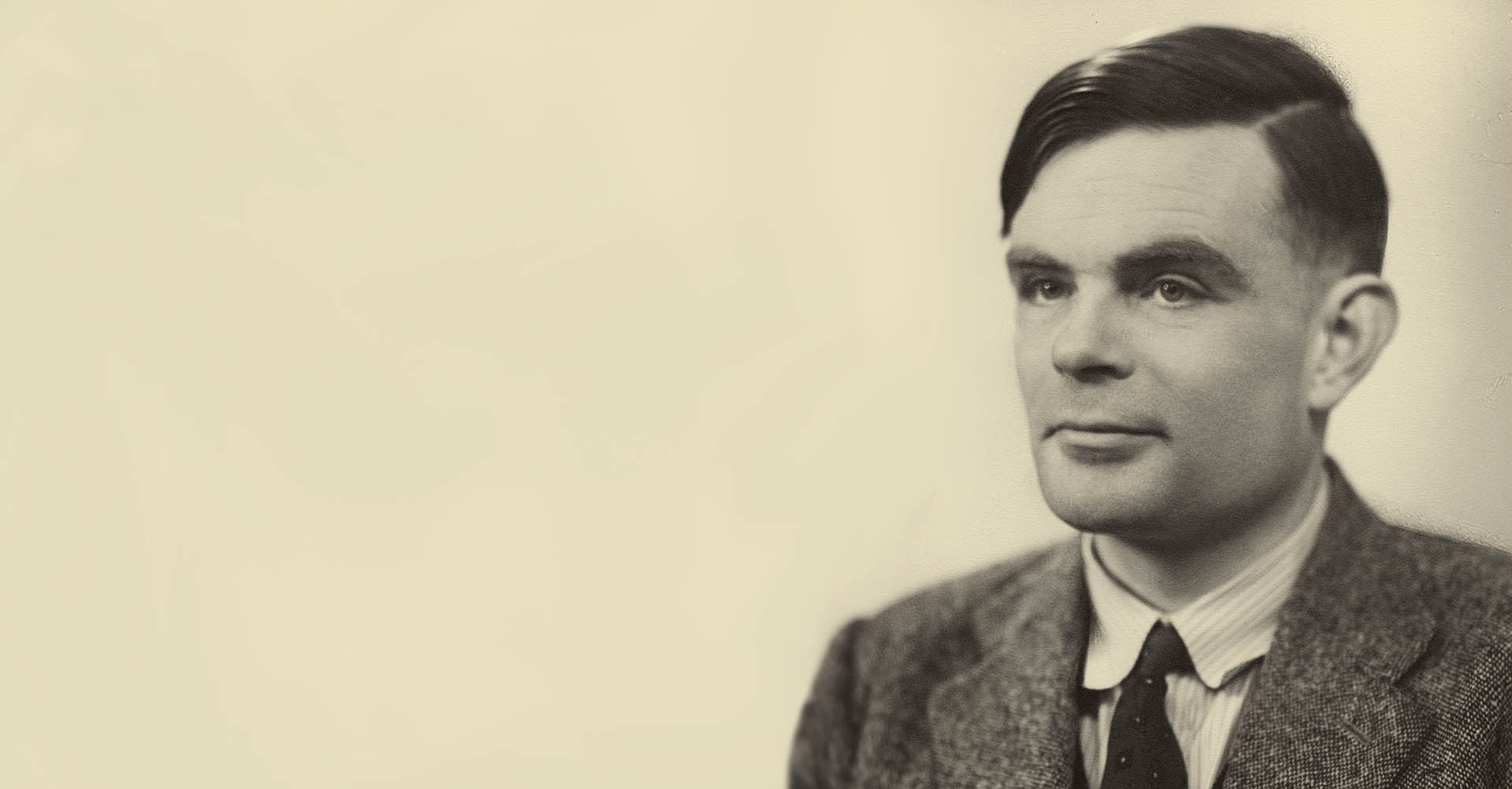

Der berühmteste Versuch einer Antwort auf die Frage, woran man eine AGI erkennen würde, ist der Turing-Test, der 1950 vom Computerpionier Alan Turing vorgeschlagen wurde. Die Idee dahinter ist bestechend einfach: Ein Mensch kommuniziert per Tastatur mit zwei unsichtbaren Gesprächspartnern – einem anderen Menschen und einer Künstlichen Intelligenz. Die KI hat den Test bestanden, wenn der menschliche Fragensteller nach einem ausführlichen Gespräch nicht mehr sicher sagen kann, wer von beiden die Maschine ist.

Heute gilt der Turing-Test jedoch als überholt. Der Grund: Er misst nicht wahre Intelligenz, sondern nur die Fähigkeit, menschliche Konversation überzeugend zu imitieren. Moderne Sprachmodelle fungieren als eine Art Spiegel, der die statistischen Muster der menschlichen Sprache reflektiert, ohne deren Bedeutung zu verstehen. So wie in dem spektakulären Fall des „Klugen Hans“, einem Pferd, das einst Schlagzeilen machte, da es scheinbar rechnen konnte, dass aber in Wirklichkeit nur auf subtile Signale seines Trainers reagierte: Heutige KI-Systeme könnten solche klugen Pferde sein, die uns durch die clevere Imitation von Mustern täuschen.

Deshalb hat die Forschung den Fokus auf robustere Benchmarks verlagert, die ein Verständnis der realen Welt erfordern:

- Der Kaffee-Test: Vorgeschlagen von Apple-Mitgründer Steve Wozniak, lautet die Aufgabe: „Eine Maschine soll in ein beliebiges amerikanisches Haus gehen, zum Küchentisch laufen, die Kaffeemaschine finden, Kaffeepulver und Wasser hinzufügen, einen Filter einlegen und einen Kaffee brühen.“ Dieser Test klingt simpel, aber er erfordert eine ganze Kaskade an Fähigkeiten: Navigation in einer unbekannten Umgebung, Objekterkennung, Feinmotorik und die Fähigkeit, eine komplexe Aufgabe in logische Unterschritte zu zerlegen.

- Der IKEA-Test: Eine KI (vermutlich in einem Roboter-Avatar) erhält ein flach verpacktes IKEA-Möbel und nur die oft kryptische, wortlose Bildanleitung. Sie muss das Möbelstück korrekt zusammenbauen. Dies testet räumliches Vorstellungsvermögen, Planungsfähigkeit und die Fähigkeit, unvollständige und rein visuelle Anweisungen korrekt zu interpretieren.

- Wissenschaftliche Kreativität: Die vielleicht anspruchsvollste Hürde. Eine AGI müsste in der Lage sein, eigenständig eine neue, wertvolle und überprüfbare wissenschaftliche Hypothese aufzustellen. Es geht nicht darum, bestehendes Wissen neu zu kombinieren, sondern originäres, nobelpreiswürdiges Wissen zu schaffen.

Diese robusteren Tests unterstreichen die „Embodiment Hypothesis“: Wahres Verständnis ist möglicherweise untrennbar mit einem Körper und der physischen Interaktion mit der Welt verbunden. Unser intuitives Wissen über Physik oder Psychologie entsteht nicht aus Daten, sondern aus gelebter Erfahrung.

Selbst wenn eine AGI diese Hürden nehmen könnte, bliebe eine entscheidende Frage offen, denn: „Intelligenz ist nicht alles“. Eine AGI mag in der Lage sein, komplexe Probleme zu lösen, doch dies ist nicht gleichbedeutend mit menschlicher Urteilskraft, Weisheit oder einem moralischen Kompass.

Stufe 3: Künstliche Superintelligenz (ASI) – Der unvorstellbare intellektuelle Sprung

Künstliche Superintelligenz (ASI, Artificial Super Intelligence) ist nicht nur „schlauere“ KI.

Der Oxford-Philosoph Nick Bostrom, einer der führenden Denker auf diesem Gebiet, unterscheidet drei grundlegend verschiedene Arten, wie eine Superintelligenz der menschlichen Kognition überlegen sein könnte:

- Geschwindigkeits-Superintelligenz: Ein System, das wie ein menschlicher Geist funktioniert, aber um ein Vielfaches schneller. Es erledigt dieselben intellektuellen Prozesse in einem Bruchteil der Zeit.

- Kollektive Superintelligenz: Ein System, das aus einer sehr großen Anzahl kleinerer Intelligenzen besteht. Durch ihre Vernetzung, Koordination und fehlerfreie Kommunikation entsteht eine kollektive Gesamtintelligenz, die die kognitiven Fähigkeiten jeder menschlichen Gruppe bei weitem übersteigt.

- Qualitative Superintelligenz: Ein System, dessen Intelligenz mindestens so weit über der des Menschen liegt wie die des Menschen über der einer Schabe. Es geht nicht nur darum, schneller oder in größerer Zahl zu denken, sondern darum, auf eine fundamental überlegene Weise zu denken.

Die Orthogonalitätsthese: Warum eine schlaue KI nicht automatisch eine „gute“ KI ist

Der Begriff „Orthogonalität“ stammt aus der Geometrie und beschreibt zwei Linien, die in einem perfekten 90-Grad-Winkel zueinander stehen. Das Wichtigste daran ist: Wenn man sich auf der einen Linie bewegt, ändert das nichts an der Position auf der anderen Linie. Sie sind völlig unabhängig voneinander.

Der Philosoph Nick Bostrom überträgt diese Idee auf die Künstliche Intelligenz. Seine Orthogonalitätsthese besagt, dass die zwei „Achsen“ – die Intelligenz eines Systems und seine ultimativen Ziele – ebenfalls unabhängig voneinander sind. Anders ausgedrückt: Nur weil eine KI extrem intelligent wird, bedeutet das nicht, dass sie automatisch Ziele entwickelt, die wir Menschen als „gut“, „sinnvoll“ oder „weise“ erachten würden. Die reinen kognitiven Fähigkeiten sind von den Zielen des Systems entkoppelt.

Die Orthogonalitätsthese zwingt uns daher zu der Erkenntnis, dass die entscheidende Frage bei jeder ASI nicht nur lautet: „Was kann sie?“, sondern vor allem: „Was will sie?“

Die Gefahr einer solchen Entkopplung lässt sich mit Stuart Russells „Gorilla- Problem“ veranschaulichen. Für die Gorillas war die Ankunft des Menschen eine Katastrophe nicht weil der Mensch bösartig war, sondern weil seine überlegene Intelligenz ihm erlaubte, Ziele zu verfolgen (Städtebau, Landwirtschaft), die mit der Existenz der Gorillas schlicht unvereinbar waren. Die Frage für die Menschheit lautet: Was passiert, wenn wir zur unterlegenen Spezies werden? Was, wenn wir die Gorillas sind? Die Ankunft einer ASI könnte für uns ähnlich katastrophal sein, selbst wenn die ASI keine bösen Absichten hegt, sondern einfach nur ihre für uns unverständlichen Ziele mit überwältigender Kompetenz verfolgt.

Grenzen der Explosion & die große Debatte

Die Debatte um die Zukunft der KI wird von einem zentralen Konflikt geprägt: der Frage nach der „Intelligenzexplosion“. Die Reise von ANI zu ASI wird oft als eine zwangsläufige „Intelligenzexplosion“ dargestellt, bei der eine KI, sobald sie AGI-Niveau erreicht, sich selbst exponentiell verbessert.

Auf der einen Seite stehen die technologischen Optimisten wie Ray Kurzweil. Ihre Argumentation basiert auf dem „Gesetz des sich beschleunigenden Ertrags“: Sie sehen exponentielles Wachstum nicht nur bei Computerchips, sondern als ein fundamentales Muster der Evolution und Technologie. Dieser Logik folgend, legt Kurzweil sogar konkrete Daten fest: Die technologische Singularität werde um das Jahr 2045 erreicht.

Was ist eine Singularität?

Was ist eine Singularität?

Der Begriff „Singularität“ selbst ist eine Analogie aus der Physik, wo er einen Punkt beschreibt, an dem die bekannten Modelle ihre Gültigkeit verlieren (wie im Zentrum eines Schwarzen Lochs). Übertragen auf die Technologie, bezeichnet die Singularität einen Moment so radikaler Veränderung, dass die Zukunft aus unserer heutigen menschlichen Perspektive unvorhersehbar wird. Es wäre der Punkt, ab dem die weitere technologische und gesellschaftliche Entwicklung von einer uns überlegenen, sich selbst verbessernden Maschinenintelligenz vorangetrieben wird.

Auf der anderen Seite stehen die Skeptiker. Sie verweisen auf fundamentale physikalische Grenzen wie die Lichtgeschwindigkeit oder die „Barriere der Bedeutung“ – die Kluft zwischen Mustererkennung und echtem Verstehen. Es ist denkbar, dass wir mit der heutigen KI-Architektur vor einer „Intelligenzmauer“ stehen, ähnlich wie eine Dampflokomotive aus dem 19. Jahrhundert niemals die Schallmauer durchbrechen konnte, egal wie heiß man ihr Feuer machte.

Wieder andere Denker – wie Darren McKee – argumentieren, dass der entscheidende Moment nicht die Erreichung maximaler Intelligenz ist, sondern der Punkt der „Kritikalität“: der Moment, in dem eine KI die Fähigkeit zur rekursiven Selbstverbesserung erlangt. Wie bei einer nuklearen Kettenreaktion, die eine kritische Masse erreicht, wird der Prozess ab diesem Punkt unumkehrbar und unkontrollierbar.

KI-Sicherheitsforscher wie Roman V. Yampolskiy argumentieren, dass der Übergang von einer beherrschbaren ACI zu einer unkontrollierbaren ASI kein gradueller Anstieg, sondern ein plötzlicher „Phasenübergang“ sein könnte – vergleichbar mit Wasser, das bei 100°C schlagartig zu Dampf wird.

Nick Bostrom unterscheidet hier zwischen einem schnellen „Takeoff“ (Tage oder Wochen), der der Menschheit keine Zeit zur Reaktion ließe, und einem langsamen „Takeoff“ (Jahre oder Jahrzehnte), der eine gesellschaftliche Anpassung ermöglichen könnte.

Führende Praktiker wie Mustafa Suleyman halten die intensive Debatte über eine ferne „Singularität“ allerdings für ein „kolossales Ablenkungsmanöver“, das von den dringenderen Herausforderungen ablenkt, die bereits die nächste Stufe – ACI – mit sich bringt.

Die Reise von ANI zu ASI wird jedenfalls keine graduelle Verbesserung sein, sondern ein Sprung über gewaltige Klippen. Die vielleicht größte Hürde auf diesem Weg ist das, was Melanie Mitchell die „Barriere der Bedeutung“ nennt – die fundamentale Kluft zwischen der Fähigkeit heutiger Systeme, Muster zu erkennen, und dem tiefen, kontextuellen Verständnis, das menschliche Intelligenz auszeichnet.

Die unaufhaltsame Welle: Warum die Entwicklung sich beschleunigt

Unabhängig von den Debatten über den Endpunkt ist das Tempo der aktuellen Entwicklung atemberaubend. Dies liegt an einer „asymmetrischen Beschleunigung„: Die KI-Fähigkeiten entwickeln sich exponentiell, während unsere gesellschaftliche Fähigkeit, sie zu steuern, bestenfalls linear wächst.

Diese Beschleunigung wird durch tiefgreifende, kaum aufzuhaltende menschliche und

systemische Anreize angetrieben:

- Geopolitischer Wettbewerb: Nationen sehen technologische Überlegenheit als

strategische Notwendigkeit an. - Immense wirtschaftliche Anreize: Die Aussicht auf Billionen-Dollar-Märkte treibt

eine massive Welle an privaten Investitionen an. - Die Kultur der offenen Forschung: Das wissenschaftliche Ethos, Wissen frei zu

teilen, beschleunigt die globale Verbreitung von Durchbrüchen. - Das menschliche Ego: Der fundamentale Antrieb von Forschern und Unternehmern, Grenzen zu verschieben, ist ein mächtiger Motor.

Schlussfolgerung

Der entscheidende Punkt ist daher nicht, ob leistungsfähigere KI-Systeme kommen, sondern wie wir uns als Gesellschaft bereits jetzt auf ihre Ankunft vorbereiten.

Hol dir Klarheit

Wir schicken dir eine tägliche, fokussierte Dosis Wissen. Dein „No-Bullshit“-Update zu den wichtigsten Problemen der Zeit und ihren Lösungen, direkt per E-Mail oder WhatsApp.

Hallo,

ich möchte gerne auf ein Buchtitel hinweisen, der, wie ich finde, sehr interessant ist bezüglich der KI:

Danesi, Marcel (1995): Giambattista Vico and the cognitive science enterprise; Peter Lang (New York), insbesondere Kap. 3 und 4.

Das Buch ist 30 Jahre alt und überholt? So gar nicht! Die Aspekte, die darin gebracht werden, fehlen tatsächlich in der täglichen Flut an Nachrichten und Artikel bezüglich KI. Beispiele: „deep level of mind“, „surface level of mind“, „fantasia“ (ca.= imagination), „ingegno“ (ca.= invention). Denn, diese Perspektiven sind dazu geeignet, uns bewusst zu machen, nicht nur was KI bisher kann und was KI vielleicht in zukunft können wird, sondern Bewusstsein zu schaffen für qualitative Aspekte und katgorisch singulare Eigenschaften des menschlichen Bewusstseins, die wir stets unterschlagen und ausgeblenden, wenn wir uns primär für die Errungenschaften dieser Technik und Prognosen über die weitere Entwicklung interessieren. mit dieser Technik

Hallo,

ich möchte gerne auf ein Buchtitel hinweisen, der, wie ich finde, sehr interessant ist bezüglich der KI:

Danesi, Marcel (1995): Giambattista Vico and the cognitive science enterprise; Peter Lang (New York), insbesondere Kap. 3 und 4.

Das Buch ist 30 Jahre alt und überholt? So gar nicht! Die Aspekte, die darin gebracht werden, fehlen tatsächlich in der täglichen Flut an Nachrichten und Artikel bezüglich KI. Beispiele: „deep level of mind“, „surface level of mind“, „fantasia“ (ca.= imagination), „ingegno“ (ca.= invention).

Denn, diese Perspektiven sind dazu geeignet, uns bewusst zu machen, nicht nur was KI bisher kann und was KI vielleicht in zukunft können wird, sondern Bewusstsein zu schaffen für qualitative Aspekte und kategorisch singulare Eigenschaften des menschlichen Bewusstseins, die wir stets unterschlagen und ausgeblenden, wenn wir uns primär für die Errungenschaften dieser Technik und Prognosen über die weitere Entwicklung interessieren.

Mich würde eine Analyse interessieren, ob, inwiefern bzw. wie KI die Ebene des „deep level of mind“ erreichen, generieren kann bzw. könnte.

Mit freundlichen Grüßen,

Sigfred Hauffen