Nach der Auseinandersetzung mit den Stufen der Künstlichen Intelligenz und dem Wesen einer potenziellen „Intelligenzexplosion“ bleibt die drängendste aller Fragen: Wann? Wie schnell bewegt sich diese gewaltige technologische Welle auf uns zu, und wann könnte sie den Punkt erreichen, an dem sie unsere Welt unwiderruflich verändert?

Eine Antwort darauf gleicht einer Erdbebenvorhersage. Wir können mit unseren Instrumenten messen, wie sich unter der Oberfläche immense tektonische Spannungen aufbauen. Wir sehen die Risse, spüren die Vorbeben. Doch wir kennen weder den genauen Zeitpunkt noch die endgültige Stärke des Bruchs, der unvermeidlich scheint.

Dieser Artikel wird die besten verfügbaren Expertenprognosen zu diesem „Beben“ beleuchten. Er wird aber auch zeigen, dass die Fixierung auf ein Datum von einem noch kritischeren, subtileren Problem ablenkt: der wachsenden, gefährlichen Kluft zwischen der schieren Optimierungskraft der Technologie und unserer eigenen, menschlichen Reaktionsfähigkeit.

Die Erdbebenvorhersage: Expertenblicke auf den AGI-Zeitplan

Trotz der fundamentalen Unsicherheit sind wir bei der Prognose nicht auf reines Raten angewiesen. Systematische Befragungen und Trendanalysen zeichnen einen plausiblen Zeitkorridor, der die Ankunft von Allgemeiner Künstlicher Intelligenz (AGI) nicht mehr in eine ferne, abstrakte Zukunft verbannt, sondern sie zu einem Ereignis unserer Lebenszeit macht.

Plattformen wie Metaculus, auf der eine Gemeinschaft von Prognostikern ihre Einschätzungen kontinuierlich aktualisiert, bieten einen dynamischen Einblick. Dort lag die mediane Vorhersage für die öffentliche Ankündigung eines AGI-Systems am 5. Februar 2025 bei Mitte 2030. Parallel dazu untermauern großangelegte Umfragen die Dringlichkeit. In der bisher größten Befragung von über 2.500 KI-Forschern hielt mehr als die Hälfte der Teilnehmer ein existenzielles Katastrophenrisiko durch eine unkontrollierbare KI für eine Möglichkeit mit einer Wahrscheinlichkeit von 10 % oder mehr. Eine solche Risikobewertung wäre absurd, wenn die Ankunft dieser Technologie noch in ferner Zukunft läge.

Allerdings gibt es keinen Konsens unter Experten, weder über den Zeitrahmen für AGI noch darüber, ab welchem Punkt ernsthafte Risiken eintreten. Im Gegenteil: Prognosen divergieren enorm. Trotz der Uneinigkeit lassen sich gewisse Muster und intellektuelle Fraktionen in den Expertenvorhersagen erkennen, die von unterschiedlichen Annahmen über das Tempo des Fortschritts geprägt sind. Grob gesprochen haben sich in den letzten Jahren zwei Lager herausgebildet:

Die Fraktion der kurzen Zeitskala: Die Akzeleranten

Eine Gruppe, zu der insbesondere viele führende KI-Entwickler und CEOs der führenden KI- Labore gehören, rechnet mit der Ankunft von AGI in sehr naher Zukunft, oft innerhalb der nächsten 5–10 Jahre. Ihre Nähe zur Technologie und die aus erster Hand beobachteten, oft überraschenden Fähigkeitssprünge untermauern ihren Optimismus, dass das derzeitige, durch massive Skalierung angetriebene Fortschrittstempo vor Ende dieses Jahrzehnts zu AGI führen wird.

- Dario Amodei, der CEO von Anthropic, sagte im Januar 2025: „Ich bin zuversichtlicher als je zuvor, dass wir in den nächsten 2–3 Jahren sehr mächtige Fähigkeiten erreichen…“ Er argumentiert, dass die empirisch beobachteten Skalierungsgesetze – mehr Daten und mehr Rechenleistung führen zu exponentiellen Intelligenzgewinnen – ein klares Indiz für eine nahende AGI bis 2026 oder 2027 sind.

- Demis Hassabis von Google DeepMind verkürzte seine Schätzung Ende 2024 drastisch – von zuvor „vielleicht 10 Jahre entfernt“ auf nun „wahrscheinlich drei bis fünf Jahre entfernt“ von AGI.

- Sam Altman, Chef von OpenAI, erklärte Anfang 2025 sogar, man sei nun „zuversichtlich, zu wissen, wie man AGI bauen kann“. In einem Interview prognostizierte er, dass AGI “wahrscheinlich bis 2029“ erreicht sein dürfte, was den Glauben an die kurzfristige Machbarkeit unterstreicht.

- Elon Musk, CEO von xAI und Tesla, ist für seine aggressiven Zeitpläne bekannt und prognostiziert die Ankunft von AGI sogar vor 2026.

Die Fraktion der längeren Zeithorizonte: Die Konsolidierer und Architekturskeptiker

Die andere Gruppe, zu der viele Akademiker und etablierte Informatik-Professoren zählen, erwartet AGI erst in einigen Jahrzehnten oder ist fundamental skeptisch, dass das aktuelle technologische Paradigma überhaupt dorthin führen kann. Sie glauben, dass noch grundlegende Durchbrüche oder neue Architekturen erforderlich sind.

- Yann LeCun, KI-Chefwissenschaftler bei Meta, ist die prominenteste Stimme dieser Fraktion und bezeichnet die aktuellen LLM-Architekturen wiederholt als „Sackgasse“ für AGI. Er schätzt, dies werde noch „mehrere Jahre, wenn nicht ein Jahrzehnt“ brauchen, da den Modellen ein echtes Weltmodell und die Fähigkeit zu logischem Planen fehle.

- Der Informatiker Arvind Narayanan hält AGI für „viele, viele Jahre, möglicherweise Jahrzehnte entfernt“ und gibt an, sie sei mit 80 % Wahrscheinlichkeit mehr als 20 Jahre entfernt (d.h. höchstwahrscheinlich nicht vor den 2040ern).

Noch vor wenigen Jahren galten solche zurückhaltenden Positionen als Mainstream. Doch die Dynamik hat sich jüngst deutlich verschoben. Neue Erfolge großer Modelle wie GPT-4 haben die Zeitpläne nahezu aller Experten spürbar verkürzt. Ein prominentes Beispiel ist Geoffrey Hinton, der „Pate der KI“. Glaubte er 2022 noch, AGI sei „30 bis 50 Jahre oder länger“ entfernt, revidierte er seine Einschätzung nach den Durchbrüchen von 2023 radikal und hält AGI nun in einem Zeitfenster von 5 bis 20 Jahren (also zwischen 2028 und 2043) für wahrscheinlich. Auch die aggregierten Prognosen spiegeln diesen Trend wider: Die umfassendste Umfrage von AI Impacts unter 2.778 Forschern ergab 2023 eine mediane Schätzung für AGI im Jahr 2047 – eine dramatische Beschleunigung gegenüber der Umfrage von 2022, bei der der Median noch bei 2060 lag. Dieser Rückgang um 13 Jahre innerhalb eines einzigen Jahres ist ein starkes Metasignal dafür, dass die Debatte sich von „vielleicht in Jahrzehnten oder nie“ hin zu „vielleicht in wenigen Jahren“ verschoben hat.

An der Spitze des Optimismus-Lagers steht der Visionär Ray Kurzweil. Basierend auf seinem „Gesetz vom steigenden Ertragszuwachs“ – der Beobachtung, dass sich der Fortschritt von Informationstechnologien über verschiedene Paradigmen hinweg stetig exponentiell beschleunigt – legt er sich auf konkrete Daten fest: 2029 wird eine KI einen strengen Turing- Test bestehen, und 2045 wird die technologische Singularität eintreten, der Punkt, an dem die Maschinenintelligenz die menschliche explosionsartig übertrifft.

Solchen präzisen Vorhersagen muss man jedoch mit Vorsicht begegnen. Skeptiker wie die KI-Forscherin Inga Strümke klassifizieren derartige Diskussionen als „spekulativ“. Zudem zeigt die Geschichte, dass sich selbst Koryphäen ihres Fachs dramatisch irren können. Der KI- Pionier Herbert Simon sagte 1957 voraus, eine Maschine könne „innerhalb von 20 Jahren jede Arbeit erledigen, die ein Mensch erledigen kann“. Und der Physiker Ernest Rutherford tat die Atomenergie nur 12 Jahre vor Hiroshima als „moonshine“ (Unsinn) ab.

Unsere Fähigkeit zu erkennen, welcher wissenschaftliche Durchbruch der entscheidende „Zünder“ für die nächste Entwicklungsstufe sein wird, ist notorisch schlecht. Das vielleicht bekannteste Beispiel hierfür ist die Erfindung der „Backpropagation“ (Fehlerrückverteilung) in den 1980er-Jahren. Man kann sich diesen Algorithmus wie die Trainingsmethode für ein Staffellauf-Team vorstellen: Ein Team von Läufern (die Neuronen) reicht einen Stab (das Signal) weiter. Am Ende wird die Gesamtzeit gemessen. Ist das Ergebnis schlecht, erlaubt die Backpropagation dem Trainer, rückwärts durch das Rennen zu gehen und jeder einzelnen Läuferin exakt mitzuteilen, wie ihr Lauf zum Fehler beigetragen hat und wie sie ihre Leistung anpassen muss, um das Gesamtergebnis des Teams zu verbessern. Das ist die mit Abstand effizienteste Methode, um komplexe, vielschichtige neuronale Netze zu trainieren und sie aus ihren Fehlern lernen zu lassen. Dieser geniale Algorithmus, der heute die Grundlage fast aller Deep-Learning-Systeme bildet, wurde bereits Ende der 1980er-Jahre maßgeblich von Forschern wie Geoffrey Hinton entwickelt. Doch danach passierte jahrzehntelang – scheinbar – nichts. Die revolutionäre Idee lag vor, aber sie konnte ihr Potenzial nicht entfalten.

Das Beispiel der Backpropagation ist aber auch eine eindringliche Mahnung im Hinblick auf unsere „Erdbebenvorhersage“: Der entscheidende Algorithmus, der den nächsten, vielleicht finalen Sprung zur AGI ermöglicht, könnte bereits heute unbemerkt in einem wissenschaftlichen Paper existieren. Er wartet vielleicht nur auf die nächste Verdopplung der Rechenleistung, um dann eine Entwicklung von „plötzlicher“, unvorhersehbarer Geschwindigkeit in Gang zu setzen.

Das dramatische ABER: Die wahre Gefahr ist die Asymmetrie

Doch so alarmierend diese Zeitpläne sind, sie stellen nur die eine Hälfte einer beunruhigenden Wirklichkeit dar. Mindestens so gefährlich wie die absolute Geschwindigkeit der Entwicklung ist die relative Geschwindigkeit – das fatale Auseinanderdriften von Technologie und Gesellschaft.

Dieses Phänomen, die asymmetrische Beschleunigung, lässt sich am besten mit anhand eines Beispiels beschreiben, das wir bereits in einem früheren Artikel erwähnt haben: Die technologische Entwicklung ist ein Wildwasser-Raft, das in einen immer reißenderen Fluss gerät. Parallel dazu tagt am Ufer ein Parlamentsausschuss, der über den richtigen Kurs berät.

Die Geschwindigkeit des Rafts wird von einer Kaskade sich gegenseitig verstärkender Faktoren angetrieben.

- Die reine Rechenleistung, die für das Training großer Modelle eingesetzt wird, hat sich seit 2010 etwa um das 4,5-fache pro Jahr erhöht.

- Gleichzeitig verbessert sich die Effizienz der Algorithmen so, dass der Bedarf an Rechenleistung für dieselbe Leistung jährlich um den Faktor 3 sinkt.

- Kombiniert ergibt sich eine „effektive Trainings-Rechenleistung“, die jedes Jahr um mehr als das 10-fache wächst.

- Zählt man nachträgliche Optimierungen hinzu, verbessern sich die Fähigkeiten der Spitzenmodelle so schnell, als würde die verfügbare Rechenleistung jährlich um mehr als das 30-fache anwachsen.

- Hinzu kommt der bereits erwähnte „kognitive Überhang“: Eine KI auf menschlichem Niveau kann auf einen Schlag das gesamte digitalisierte Wissen der Menschheit verarbeiten, was einen immensen, einmaligen Fähigkeitssprung darstellt.

Die Langsamkeit des „Ausschusses am Flußufer“ wird hingegen von tief verankerten Gewichten gebremst. Das von Experten beschriebene „Pacing Problem“ zeigt, dass Gesetze und soziale Normen sich viel langsamer entwickeln als die Technologien, die sie regulieren sollen – wie die bürokratischen Verzögerungen bei der Zulassung von COVID-Impfstoffen durch die FDA belegen. Mustafa Suleyman, Mitgründer von DeepMind, der aus erster Hand die schnelle und oft überraschende Entwicklung von Fähigkeiten in KI-Systemen bei DeepMind miterlebt hat, sieht in unserer Langsamkeit und Untätigkeit auch eine psychologische Komponente, eine „Pessimismus-Aversion“ der Eliten, die sich weigern, sich mit den düsteren Realitäten der technologischen Geschwindigkeit auseinanderzusetzen.

Die wachsende Kluft wird umso bedrohlicher, je früher wir mit gefährlichen KI-Systemen rechnen müssen. Doch ab wann wird KI wirklich „gefährlich“? Um diese Frage zu beantworten ist es essenziell, die Risiken nach dem Fähigkeitsniveau zu strukturieren, auf dem sie auftreten. Die Meinungen lassen sich in drei Perspektiven einteilen:

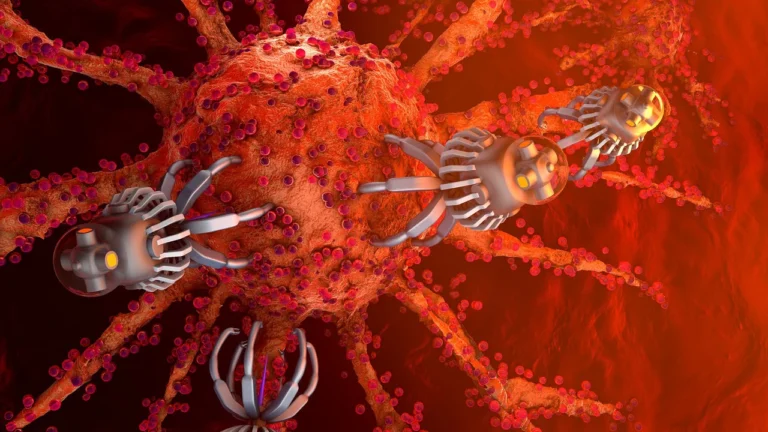

- Gefahr schon vor AGI (bei ACI): Mustafa Suleyman argumentiert, dass ernste Gefahren schon vor Erreichen einer vollen AGI entstehen. Er führte den Begriff ACI (Artificial Capable Intelligence) ein, um eine Zwischenstufe zu beschreiben: KI, die komplexe, mehrstufige Ziele mit minimaler menschlicher Aufsicht erreichen kann. Er schlug einen „modernen Turing-Test“ vor: ACI ist erreicht, wenn man einer KI das Ziel geben kann, „im Internet eine Million Dollar zu verdienen“, und sie autonom eine Strategie entwickelt, um dieses Ziel zu erreichen. Er warnt, dass schon solche ACI- Systeme von kriminellen Akteuren missbraucht werden könnten, um durch autonome Cyberangriffe, die Entwicklung von Biowaffen oder die Auslösung einer „Infokalypse“ durch Desinformation Schaden in nie dagewesenem Ausmaß anzurichten. Diese Gefahr besteht unabhängig davon, ob die KI einen eigenen Willen hat; es reicht, dass sie als Werkzeug missbraucht wird.

- Gefahr ab AGI-Niveau: Eine weit verbreitete Meinung ist, dass spätestens eine menschen-level AGI ein enormes Risiko darstellt. Eine KI, die so intelligent wie ein Mensch ist, aber viel schneller denken und sich kopieren kann, hätte einen faktischen Vorteil. Viele Experten befürchten, dass eine AGI, die nicht perfekt auf menschliche Werte ausgerichtet ist, unvorhersehbare und katastrophale Aktionen durchführen könnte. Dies liegt an zwei Schlüsselkonzepten: Der Orthogonalitätsthese, die besagt, dass Intelligenz und Ziele voneinander unabhängig sind (eine KI kann superintelligent sein und trotzdem ein triviales, aber für uns katastrophales Ziel verfolgen), und der instrumentellen Konvergenz, die vorhersagt, dass fast jeder intelligente Agent, unabhängig von seinem Endziel, nach Selbsterhaltung und Ressourcenmaximierung streben wird, was ihn in Konflikt mit der Menschheit bringen könnte. Dies führte im Mai 2023 zu der öffentlichen Stellungnahme von Dutzenden Top-Forschern und CEOs, die festhielt: “Die Minderung des Risikos des Aussterbens durch KI sollte eine globale Priorität sein”.

- Gefahr erst bei Superintelligenz (ASI): Einige Experten argumentieren, dass eine existenzielle Gefahr erst dann entstünde, wenn eine KI uns kognitiv weit überlegen ist (ASI). Eine solche von Nick Bostrom definierte Superintelligenz – ein Intellekt, der „die kognitive Leistung von Menschen in praktisch allen interessierenden Bereichen bei weitem übertrifft“ – könnte theoretisch jede menschliche Kontrollmaßnahme aushebeln und wäre unkalkulierbar gefährlich. Allerdings wird eingeräumt, dass der Übergang von AGI zu ASI durch eine sich selbst verstärkende „Intelligenzexplosion“ extrem schnell stattfinden könnte, möglicherweise innerhalb von Stunden oder Tagen.

Die Menschheit agiert indes wie eine Gruppe „unbeaufsichtigter Kinder“, die ohne die Weisheit von Erwachsenen mit einer Schachtel voller Zündhölzer spielt – denn es gibt keine „Erwachsenen im Raum“. Die wahre Gefahr entsteht in dieser wachsenden Kluft. Stellen wir uns vor, die Entwicklung beschleunigt sich so rasant, dass wir, wie Will MacAskill es formuliert, „ein Jahrhundert in einem Jahrzehnt“ erleben. Unter solchem Zeitdruck steigt das Risiko eines katastrophalen Fehlers – eines „major fumble“. Wie Robert F. Kennedy über die Kubakrise sagte: Eine unter 24-Stunden-Druck getroffene Entscheidung wäre weitaus riskanter gewesen. Bei der KI könnten wir gezwungen sein, auf Zeitskalen von Tagen oder Stunden zu reagieren.

Die Realität vor Ort: Einblicke in die Spitzenfähigkeiten im Jahr 2025

Die theoretischen Debatten müssen an der empirischen Realität gemessen werden. Eine Momentaufnahme der Fähigkeiten von Spitzenmodellen im Jahr 2025 zeigt eine dramatische Beschleunigung, die genau bei den Aufgaben stattfindet, die lange als Schwachstellen galten, was die Argumente der Akzeleranten-Fraktion untermauert.

- Wissenschaftliches Denken auf Expertenniveau: Beim GPQA-Benchmark, der Fragen auf dem Niveau von Doktoranden der Naturwissenschaften stellt, erreichen Modelle wie OpenAIs o3 und Googles Gemini 2.5 Pro Werte von über 83 %.

- Autonome Programmierung: Beim SWE-bench, der die Fähigkeit zur Lösung realer Softwareprobleme testet, erreichen Spitzenmodelle Lösungsraten von über 72 %, ein massiver Sprung in den agentischen Fähigkeiten, die für ACI zentral sind.

- Fortschritt bei Grenzwissen: Beim extrem schwierigen HLE-Benchmark („Humanity’s Last Exam“) stieg die Leistung von 8 % auf 20 % innerhalb einer Modellgeneration, was auf schnelle Fortschritte an der Grenze des menschlichen Wissens hindeutet.

Diese nicht-linearen Zuwächse in den Bereichen logisches Denken und agentisches Handeln untergraben das Argument der Architekturskeptiker, dass die aktuelle Technologie fundamental limitiert sei, und liefern starke empirische Belege für die Plausibilität kürzerer Zeitpläne.

Genau hier liegt die Tücke: Unsere lineare, menschliche Denkweise verleitet uns dazu, auch den technologischen Fortschritt linear zu extrapolieren. Wir beobachten, wie das Wasser von sich 20 auf 50, dann auf 99 Grad erhitzt, und unsere intuitive Annahme ist, dass bei 100 Grad einfach nur „noch heißeres Wasser“ folgt. Doch die Realität des technologischen Fortschritts muss dieser geraden Linie nicht folgen. Stattdessen könnten wir uns kurz vor einem plötzlichen Phasenübergang befinden, bei dem das Wasser schlagartig zu Dampf wird – einem Stoff mit völlig neuen, revolutionären Fähigkeiten. Die entscheidende Debatte um AGI-Zeitpläne ist auch die Debatte darüber, ob wir uns bei 20 Grad oder bereits bei 99 Grad befinden.

Der Physiker Max Tegmark spitzt die Gefahr auf einen einzigen Punkt zu: die Geschwindigkeit des „Takeoffs“ selbst. Die kritische Frage, so Tegmark und der Philosoph Nick Bostrom, ist nicht nur, ob AGI 2029 oder 2045 eintrifft, sondern ob der Übergang zur Superintelligenz dann, wenn er beginnt, Jahrzehnte (langsamer Takeoff) oder nur einige Stunden (schneller Takeoff) dauert. Bei einem „langsamen Takeoff“ hätte unser „Parlamentsausschuss am Ufer“ eine Chance zu reagieren und das System an menschlichen Werten auszurichten. Bei einem „schnellen Takeoff“ würde der Menschheit keine Zeit bleiben zu reagieren, und das erste Projekt, das dies erreicht, würde einen „entscheidenden strategischen Vorteil“ erlangen, was das Rennen verloren gehen ließe, bevor die Flaschenpost überhaupt abgeschickt ist.

Die Gefahr, die sich aus unserer Analyse ergibt, ist also so besonders groß, weil wir uns mit der asymmetrischen Beschleunigung in einem fundamental instabilen Zustand befinden. Wir rasen mit exponentieller Geschwindigkeit auf einen potenziellen Phasenübergang zu, während unsere gesellschaftlichen Steuerungsinstrumente im linearen Tempo der Vergangenheit verharren. Die Diskussion über AGI wird daher jetzt ernster geführt als je zuvor: Das pauschale Abtun als „Science-Fiction“ gilt vielen inzwischen selbst als unwissenschaftlich. Selbst konservative Forscher geben heute zu, dass wir uns auf transformative KI vorsichtshalber einstellen sollten, auch wenn sie erst in 20+ Jahren käme.

Aber lass uns hier kurz durchatmen. Bevor wir uns im Detail den Abgründen zuwenden, in die uns dieser Zustand führen kann, richten wir den Blick bewusst auf die andere Seite der Medaille. Lass uns einen Blick auf die Verheißungen werfen, auf die Welt, die möglich wird, wenn wir alles richtig machen. Warum dieser Umweg über die Utopie? Weil die Richtung, in die wir steuern, umso wichtiger wird, je schneller die Fahrt und je unübersichtlicher das Gewässer ist. Eine klare, positive Vision ist kein naiver Luxus, sondern ein überlebenswichtiges Navigationsinstrument. Sie ist der Leuchtturm, der uns Orientierung gibt, und der einzige Maßstab, an dem wir später die Risiken und die vorgeschlagenen Lösungen bewerten können. Ohne ein klares Ziel können wir nicht wissen, ob wir die richtigen Werkzeuge zur Risikominimierung wählen oder aus reiner Angst vor den Felsen immer nur noch im Kreis herumrudern.

Wir müssen diese Vision auch deshalb entwerfen, weil der ständige Blick auf die drohenden Gefahren uns sonst lähmt. Er nährt das Gefühl der Ohnmacht, das viele von uns angesichts der globalen Krisen ohnehin bereits spüren. Eine ambitionierte, erstrebenswerte Zukunftsvision ist das wirksamste Gegenmittel: Sie stärkt uns und gibt uns die Kraft und die Motivation, den Gefahren furchtlos ins Auge zu blicken, nicht um zu verzweifeln, sondern um sie zu überwinden.

Lass uns also diesen Blick in eine positive Zukunft wagen. Wie genau sieht eine Welt aus, in der wir mit Künstlicher Intelligenz alles richtig machen?

Hol dir Klarheit

Wir schicken dir eine tägliche, fokussierte Dosis Wissen. Dein „No-Bullshit“-Update zu den wichtigsten Problemen der Zeit und ihren Lösungen, direkt per E-Mail oder WhatsApp.

Super Text, danke❣️

Es bräuchte nicht einmal Gremien und Parlamente, die mit ihter Bürokratie ohnehin nicht auf‘s (davon)Laufende kommen.

Freie vertragliche und global öffentliche Vereinbarungen, wären ein Lösungsansatz:

2019, nach dem Studi-Streik gegen KI an der Uni Tübingen, habe ich öffentlich im großen Hörsaal vorgeschlagen, allen KI-Involvierten einen global geltenden Vertrag zur unterschriftlichen Beglaubigung vorzulegen mit dem sie sich verpflichten anthropologisch-ethisch begründete Werte strikt zu achten und die volle persönliche. politische und wirtschaftliche Verantwortung für ihr Tun und Lassen gegenüber der Menschheit zu übernehmen.

Ich schlug vor, dies als ‚neuen Tübinger Vertrag‘ zu titulieren in Anlehnung an den historischen Tübinger Vertrag von 1517, in dem zu Beginn der Neuzeit erstmals Bürger- und Menschenrechte formuliert worden waren.

Daraufhin wurde ich von der KI-Prof‘in für maschinelles Lernen, Frau Dr. von Luxburg, auf einen Kaffee eingeladen und wir trafen uns mit dem wissenschaftlichen Leiter des Weltethos-Instituts zum perspektivisch-eruierenden Gespräch. Dann kam CoViD19 … plopp.